革新的技術実証1号機搭載実験

深層学習を応用した革新的姿勢センサの開発

Deep Learning Attitude Sensor

DLAS Project

Top > 地球カメラ(ECAM)

AIによる軌道上リアルタイム画像認識実験

地上では、もはや当たり前の様に使われているDeep Learning(深層学習)などの人工知能による画像認識ですが、例えばSNSサービスの顔認識などには極めて精巧なアルゴリズムを大型計算機では知らせることで実現しています。我々は宇宙利用の新しい価値を創出するために、この様な画像認識技術を衛星軌道上で、しかもリアルタイムで使ってみたいと考えています。ここでは、小さいながら野心的かつかなり挑戦的な画像認識実験"ECAM"について紹介致します。

衛星によるリモート観測の弱点

宇宙空間から地球を観測する人工衛星は、災害監視への応用や新しい情報ビジネスの可能性を感じさせますが、実際には大きな制限の中で運用されています。宇宙という極限環境、寸法・重量制限に加え、実際のデータ利用・サービスを実現する上で現状の最大の制限は通信です。衛星を運用するための地上からのアップリンク、逆に取得した情報を地上に送信するダウンリンクいずれも法律によって厳格な制限があるうえ、そもそも許可を得るのがきわめて難しい状態です(国内法による制限に加え、国際周波数調整が必要となり、複雑な申請手続きと長い年月がかかります)。たとえ、免許がとれたとしても、打ち上げ頻度の多い極軌道の場合、日本からは1日に数回しか通信のチャンスがありません。これでは、たとえ素晴らしい高性能センサを開発したとしても、データ量も膨大となってしまい、災害が収まってからデータが出てくるという状況になってしまいます。

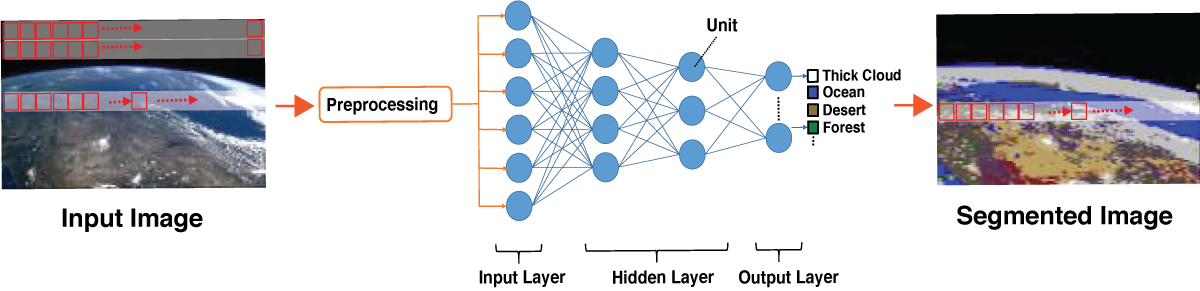

そこで我々が考えたのは衛星軌道上での「情報の選別・圧縮」です。例えば、我々が目指す紫外線突発天体サーベイを例に挙げると、通常の星には興味がないので、変動天体の座標・明るさ・発生時刻だけが分かれば速報情報としては十分なわけです。この程度の情報量であれば、高速通信回線を使わずとも別の通信手段でほとんどリアルタイムで地上に情報を伝達することができます。この様な方法は、天体観測のみならず地上観測、特に情報の鮮度が重要な災害監視や情報収集で価値を発揮するはずです。人間目に頼らず衛星が勝手にイレギュラーを発見するために必要なのがDeep Learningに代表される画像認識技術です。既に、地上では当たり前に使われている技術ですが、電力・計算機資源に乏しい衛星軌道上で実現するために、我々は衛星搭載用に最適化したシンプルなアルゴリズムを開発しました(図3-1)。

図3-1: DLASに搭載された画像識別器の概略図。Preprocessにおいて、16×16ピクセルごとの輝度情報などを識別器にわたす。

ミッション1: 軌道上リアルタイム画像認識

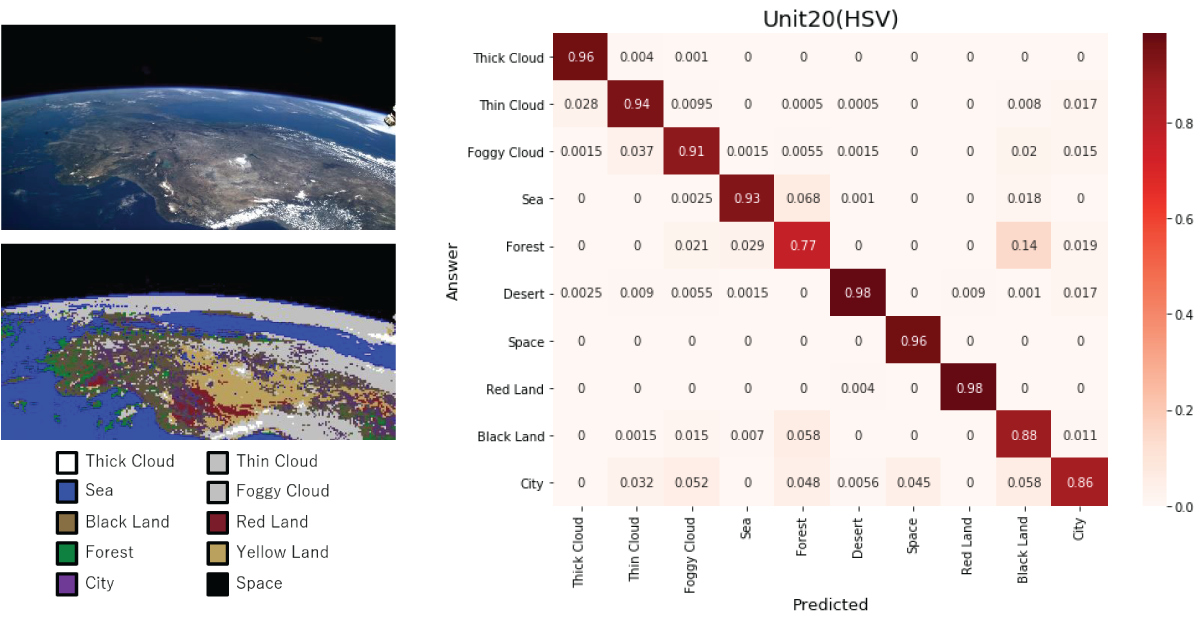

ECAMはSTTのバッフルに取り付けられた小型可視光カメラです。これで゙得た画像をオンボードコンピュータをつかってその場で解析を行います。このミッションでは、地球表面の海、陸地 (市街地、緑地、砂漠等、礫砂漠)、雲・氷雪・宇宙空間等のクラス分類を行います。

Deep Learningによる画像認識で重要なのが”教師データ”によるアルゴリズムの学習です。学習処理自体は計算機が行う作業なので高性能計算機を使えば1日程度で完了しますが、大変なのがこの教師データの準備です。ECAMはもう一つのミッションに使うため視野が広く常に地平線方向を観測しており、これと同様の公開されている衛星画像を目視で詳細に確認し、写っている物体が何であるかをタグ付けしました。この地味な作業がじつは識別器の精度を決定づけるものであり、どうしても人間が行わなければなりません。

この様に、入手可能な衛星画像で予め学習はしていますが、実際に宇宙に行って取得した画像とは異なる可能性があります。そこで、本実験では、学習に使うための衛星画像を撮影し、地上で再学習を行い、より高い精度での画像識別を実現します。学習データの取得はおよそ半年をかけて行い、後半では再調整を行った識別器でのより高精度な画像識別実験を行います。

図3-2: 国際宇宙ステーションから撮影された画像をつかった画像識別器の動作実証。800万画素の画像に対しおよそ4秒で識別を完了する。識別精度はおよそ90%に達する。

ミッション2: 可視光地球画像を用いた3軸姿勢計測

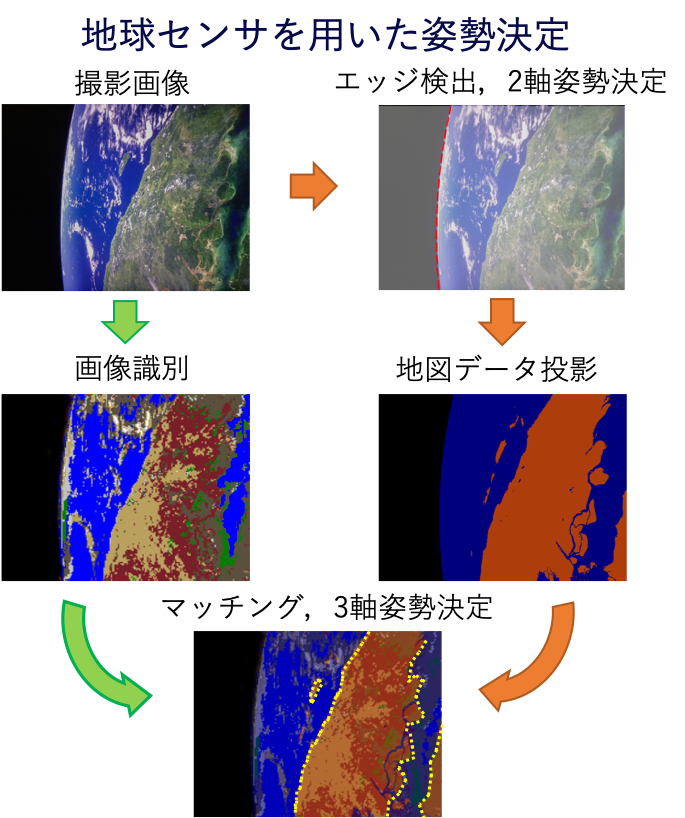

衛星の姿勢センサとして地球を使う地球カメラは既に存在しているが、それらの多くは赤外線で地球を検知・撮像することで、地球の有無もしくは地球のエッジを検知することで、かなり粗い姿勢推定を行うものでした。本実験では、普通の可視光・カラーカメラで撮影した地球画像を使って、より正確な衛星の姿勢決定を実現したいと考えています。可視光のカメラは赤外線のカメラに比べてば安価で入手性がよく、最近の携帯電話用カメラなどを見ても分かる通り極めて小さいため、特に超小型衛星にはもってこいのセンサです。単純には地球と漆黒の宇宙を識別するだけで従来の地球センサとしての機能は実現できます。しかし、我々はさらに一歩進んで、3軸姿勢制御に挑戦します。その鍵をにぎるのが画像認識です。

もし、より高度な画像認識が実現するなら、雲間から見える陸地、海、地球の輪郭(地平線)が分かることになります。オンボード・コンピュータに予め世界地図の情報を保持しておき、これと観測した地形情報を比較することで、現在の衛星の姿勢を推定することもできるはずです(もちろん、地上のどこを見ているのかもわかります)。しかも、従来の地球センサ(2軸)とは異なり、ピッチー、ヨー、ロールの3軸を比較的高い精度で決定することができます。もしこの技術が実現すれば、ペイロードのリソース制限が厳しい超小型衛星でも、観測用カメラと姿勢制御のデュアルユースが可能となり、さらなるバスの小型化、低コスト化、高性能化を実現できます。

図3-3: 雲の隙間から見える陸地の形を認識し、予め搭載している地図情報と比較することでより正確な衛星の姿勢決定を実現する。

地上実証実験

可視光画カメラを使った3軸姿勢決定は、軌道上即時画像認識と地形情報のマッチングという2つの独立した開発要素があり、装置の簡単さに比べてソフトウェア技術的にはにはかなり挑戦的です。そのため、このプログラムが軌道上で本当に機能するのかを確認する必要があります。我々は大型ディスプレイにシミュレータで生成した地球の画像を表示し、それを地球に見立てて姿勢決定実験を行いました。ディスプレイの反射光や表現できるコントラストに限界があるため、必ずしも衛星画像と同等の識別精度は達成できていませんが、撮影、画像認識、地形パターンマッチング、座標計算を10秒以内に完了できることを確認しています。陸地と海の比率によっても識別精度は変わりますが、条件の良い場合で0.1度の姿勢決定精度を達成しています。

図3-4: RAPIS-1の軌道から見える地球の画像をシミュレートして大画面ディスプレイに投影し、実際に撮影して姿勢計算ができるかどうか、できた場合の姿勢決定精度を評価した。